L’intelligenza artificiale è davvero diventata intelligente, forse anche troppo visto che, da quando parla con gli umani, si esprime anche per neologismi – persino ben formati – basati sulla conoscenza delle regole grammaticali e delle strutture linguistiche. Produce parole che hanno senso, che assomigliano alle parole della lingua italiana ma che di fatto non esistono. Ricorderete “petaloso”, il famoso aggettivo formato, da un bambino delle elementari, dalla combinazione del sostantivo “petalo” e del suffisso “-oso”, che dal 2016 indica letteralmente la caratteristica di un fiore di avere molti petali. Così chatGPT ha creato il suo “pancristico” con tanto di riferimenti bibliografici (inesistenti ndr).

Gli avevo chiesto: “Com’è che in italiano potremmo rendere il termine panchreston?”

Il termine “panchreston” è stato utilizzato da molteplici pensatori e studiosi nel corso degli anni, inclusi filosofi, linguisti e antropologi, per fare riferimento a una parola o ad un concetto che è così ampiamente applicabile da non avere un significato specifico. Il noto ecologo e biologo evolutivo americano, Daniel Simberloff, lo ha applicato per esempio al concetto di “natura”. Cosa intendiamo quando diciamo “natura”? Quell’insieme di esseri che nascono, crescono e muoiono e l’ambiente che abitano? Umani inclusi? E se l’uomo è incluso perché parliamo della natura come un’entità da proteggere, separata da noi? E quando invece parliamo di volontà della Natura – con lettera maiuscola – personificandola? Il termine “natura” è un classico esempio di espressione “panchreston”, una parola che vuol dire tutto e che vuol dire nulla, così come chiarisce l’etimologia greca, per cui “pan” sta per “tutto” e “chreston” per “utile”.

Bene, secondo chatGPT in italiano il termine corrispondente sarebbe “pancristico” e specifica – forse giustificando una prevedibile sciocchezza – “ è talvolta usato come equivalente della parola inglese “panchreston”, tuttavia, vale la pena notare che “pancristico” non è una parola comunemente usata nell’italiano moderno e potrebbe non essere immediatamente compresa da tutti i parlanti.”

Se non fosse che c’è da piangere – visto che mezza popolazione ha già gridato alla scoperta del secolo, paventando la capacità dell’intelligenza artificiale di scrivere temi, articoli, trattati e review senza spreco d’intelligenza umana – ci sarebbe da ridere a parlare con il nostro nuovo Dario Fo, ci sarebbe da parlarci tutte le sere e intrattenersi con questi, sifapperdire, grammelot 2.0.

La verità è che, a parte il veto che giustamente il Garante della privacy italiano aveva posto, forzando la società OpenAI ad oscurare il sito in Italia fino a che non ha reso conto di come avrebbe trattato i dati personali dei suoi utenti, tutto il resto delle preoccupazioni discusse dai media sono davvero infondate. (Per preoccupazioni serie, come la questione etica dell’intelligenza artificiale, clicca qui).

Perché mai, per richiamare solo uno degli scenari paventati, sarebbero i professori di scuola a doversi preoccupare? Ce lo vedete uno studente a verificare il contenuto di un tema creato ta chatGPT in cui gli aveva chiesto di fare la parafrasi della Divina Commedia o il commento del terzo capitolo dei Promessi Sposi?

“Il terzo capitolo dei “Promessi Sposi” di Alessandro Manzoni si intitola “I Fabbri”.

Gli chiede, per eccesso di zelo (e anche perché gli piace testare le sue capacità di conversazioni cosi “umanose”) : “Sei sicuro?”

“Mi scuso, mi sono accorto che ho fatto un errore nella risposta precedente. Il terzo capitolo dei “Promessi Sposi” di Alessandro Manzoni si intitola “I Falegnami” e non “I Fabbri”. [ogni riferimento a persone esistenti o fatti realmente accaduti non è assolutamente casuale, ho avuto davvero questa conversazione con l’amico digitale, nda].

Lo studente che svolge il compito con chatGpt, forse non si allarmerà nel vedere un Renzo filatore di seta che si industria come falegname, potrebbe verosimilmente pensare “ma chi pensa alla seta in tempi di carestia?”. Ma un professore, immagino, non avrà bisogno di intraprendere grosse elucubrazioni per capire che c’è qualcosa che non va.

Il nostro “pancristico”, seppure usato uno o due volte in ambito teologico, ce la potrebbe dire lunga sulla – altrettanto lunga – strada che questa intelligenza deve fare per poterci far gridare all’utility del secolo, almeno nelle questioni più sciocche poste all’attenzione generale.

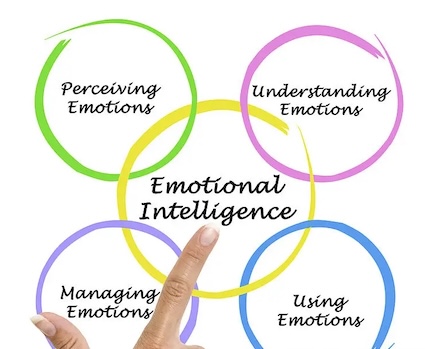

Fa sorridere poi che il sottoinsieme dell’intelligenza artificiale, che è alla base di chatGPT, si chiami deep learning, che sta per apprendimento profondo. Un eufemismo. Ma è così che apprendiamo anche noi, i linguisti e i sociologi ricorderanno la teoria dei simboli di Elias.

In effetti il deep learning è un modo per addestrare i computer a fare cose che normalmente richiedono l’intelligenza umana, per esempio riconoscere oggetti nelle immagini o comprendere il linguaggio naturale. Lo fa utilizzando un tipo di programma chiamato rete neurale, che si ispira alla struttura del cervello umano.

Una rete neurale è costituita da strati di neuroni artificiali collegati tra loro. Ogni neurone acquisisce alcuni dati, li elabora e passa il risultato allo strato successivo di neuroni. Tutto l’elaborato del livello finale è quello che l’intelligenza artificiale ha ritenuto essere prevedibilmente quello che un umano può produrre.

Durante il processo di addestramento, la rete riceve una grande quantità di dati e sulla base di questi regola le sue connessioni tra i neuroni per migliorare le sue previsioni. Questo è in soldoni il processo noto come backpropagation, una specie di maestra che valuta i compiti di uno studente e gli dice quali errori ha commesso e come correggerli. Così nel tempo, lo studente/la rete migliora nel produrre output/compiti corretti. Infatti “GPT” sta per “Generative Pre-trained Transformer”. La parte “generativa” del nome si riferisce al fatto che il modello può generare nuovo testo in base all’input, mentre “pre-addestrato” si riferisce al fatto che il modello viene addestrato su grandi quantità di dati prima di essere messo a punto per un compito specifico. La parte “transformer” del nome si riferisce alla capacità del meccanismo di concentrarsi su parti specifiche dell’input ed elaborarle a parole sue.

Immaginiamo di star leggendo un lungo libro e di doverlo riassumer a parole nostre: procediamo prestando attenzione alle parti più importanti del testo e per questo potremmo dover leggere alcuni passaggi più volte per comprenderli appieno. Ecco, questo è simile a quello che fa il “transformer”: usa un meccanismo, chiamato “attenzione” per identificare le parti più importanti dell’input e controlla più volte le parti salienti di un testo per costruire una rappresentazione accurata di quella sequenza di parole ma con parole diverse. Un “sintesucco” – direbbe chatGPT se gli fosse chiesto di porlo in termini fantasiosi, non senza i dovuti avvertimenti: “Guarda, amico, il linguaggio dell’intelligenza artificiale è come un orsacchiotto robotico peloso: sembra un po’ strano, ma in fondo è solo un giocattolo divertente e innocuo! Non ha denti affilati né artigli acuminati, solo una serie di regole e istruzioni che si combinano per creare intelligenza artificiale. Quindi, non preoccuparti troppo del linguaggio dell’intelligenza artificiale. È come un vecchio zio un po’ eccentrico: potrebbe sembrare strano o difficile da capire, ma in realtà è solo un po’ diverso dalla norma. E chissà, potrebbe anche sorprenderti con alcune idee geniali ogni tanto!

Il punto è che sarebbe davvero da umani intelligenti concentrarsi sulle cose che ChatGPT è in grado di fare in maniera innocua, tra queste la capacità per esempio di mettere i concetti in termini più semplici, masticandoli per renderceli meno indigesti. E se uno studente o due ne beneficiassero, sarebbe davvero una gran bella evoluzione.